| about institute |

| structure |

| employees |

| academic council |

| technical base |

| researches |

| projects |

| e-archive |

| library |

| feedback |

| contact us |

|

|

| ìåòåîñòàíöèÿ |

High-performance computing resources

ICM SB RAS has the following high-performance resources that operate in the mode of collective use (with remote access over a telecommunications network).

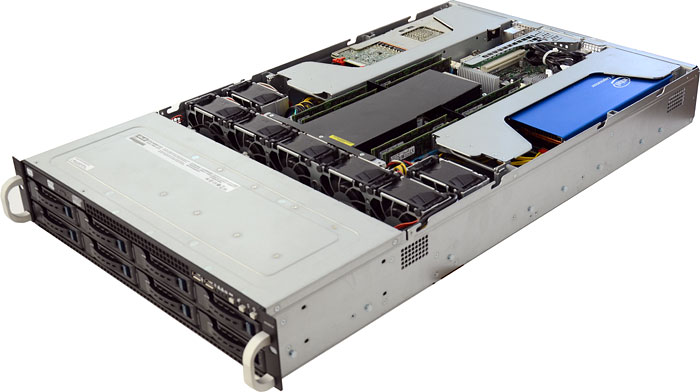

Universal cluster x86-x64

The cluster has 400 compute cores, peak performance 14 TFlops (double precision).

The equipment includes:

- 10 computing modules with 2 Intel Xeon E5-2698 processors (20 cores frequency from 2.2 to 3.6 GHz) and 256 GB of RAM;

- control unit — 2 Intel Xeon E5-2450 processors (8 cores, 2.1 GHz frequency) and 24 GB of RAM;

- network storage PROMISE Vess R2600iD-64 TB, for the organization of storage of user data;

- 10GbE communication environment with passive SFP + connections and managed high-performance DXS-3600-32S switch (24 SFP + ports, 960 Gbps communication matrix);

- uninterruptible power supply APC SURT15KRMXLI with a capacity of 15 êVA.

Installed software:

- Linux operating system

- Compilers GNU C/C++ GNU Fortran Intel C/C++ and Intel Fortran

- Communication environments-MPI (MPICH1, MPICH2, LAM)

- DVM parallel programming system

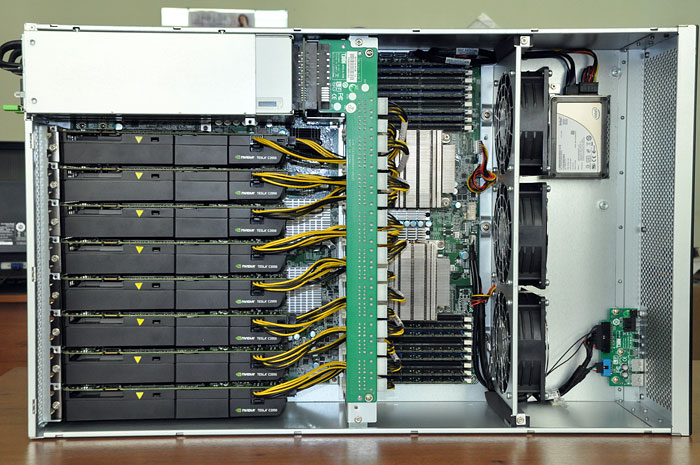

Server with NVIDIA Tesla graphic calculators

Server with GPU graphics processors (8X NVIDIA Tesla C2050) — 8.24 TFlops (single precision). Installed software MathWorks: MATLAB, Simulink and Parallel Computing Toolbox with support for graphical calculations.

Server with Intel MIC

Computing server with Intel MIC architecture (2x Intel Xeon Phi) — peak performance 2.3 TFlops (double precision). The Intel Cluster Studio XE package is installed.

Storage systems

IÑM SB RAS uses in its work several data storage systems (DSS) with a total capacity of more than 150 TB including:

- PROMISE Vess R2600iD-64 TB, storage of backup copies of information systems and user data (2017)

- Synology DS1813+ — 32 TB, QNAP TS-639 Pro, storage and processing of satellite data (2013)

- Synology RackStation RS3412RPxs — 30 TB data for virtualization systems and cloud services (2013)

- Synology RackStation RS3412RPxs — 30 TB data storage of computational experiments (2012)

On all computing resources with telecommunication access the statistics of use is conducted, access from a city scientific and educational network at a speed to 1 Gbit/s, and from public networks of 100 Mbit/s is supported.

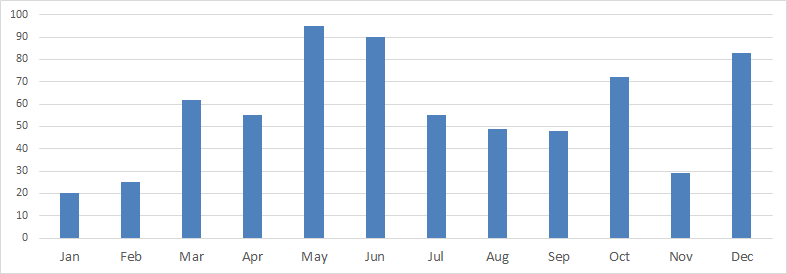

The graph below shows the load Of the universal cluster of IVM for 2018.